Včera se začaly prodávat nové grafiky AMD Radeon RX 6800 a RX 6800 XT (a rychle také přestaly, protože omezené počty, které měly obchody na skladě pro začátek prodejů, byly rychle pryč, stejně jako s Ampere od Nvidie). Tím pádem je na čase se podívat, jak to s nimi dopadlo v testech.

Modely karet a něco o architektuře a nových funkcích jsme již probírali při odhalení karet. Také ke specifikacím už se vracet nebudeme. Pokud potřebujete osvěžit paměť, zde jsou parametry pro Radeon RX 6800 a zde pro Radeon RX 6800 XT.

Výkon v recenzích

Testy zatím z naší skvadry vyvolených, z jejichž recenzí čerpáme (jde o stálou sestavu kvůli konzistenci), vydaly weby Tom's Hardware, techPowerUp (ten má recenzi referenčního Radeonu RX 6800, RX 6800 XT a separátně ještě test přínosů funkce Smart Access Memory), PC Perspective a německý ComputerBase. AnandTech zatím test nemá, alespoň pro Linuxáky ovšem již má článek Phoronix (celkový test a OpenCL/ROCm).

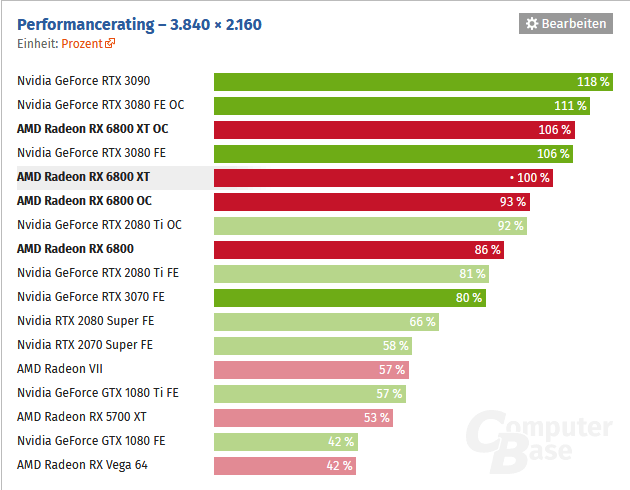

Výsledky jsem bral z ComputerBase, techPowerUpu a Tom's Hardware, uvádíme procenta ze všech tří recenzí, vždy postupně v tomto pořadí. Na tom můžete vidět, jak se výsledky mohou lišit podle testovací metodiky. Nejprve testy z her bez raytacingových efektů, které jsou Radeonům mnohem lépe, než ty raytracingové – o tom bude řeč poté.

1080p

V rozlišení 1920 × 1080 bodů má Radeon RX 6800 XT o 5 %/6 % nižší výkon proti GeForce RTX 3080 v testu ComputerBase a TPU, ale u Tom's Hardware skončil RX 6800 XT o 2 % rychlejší (jen v tomto rozlišení). A výkon je o 10 %/8 %/4 % nižší proti RTX 3090. Radeon RX 6800 XT je ale o 13 %/10 %/20 % rychlejší než RTX 3070 a o 15 %/10 %/ 18% rychlejší než RTX 2080 Ti. Proti proti loňskému Radeonu RX 5700 XT je o 60 %/47 %/57 % rychlejší.

Slabší bráška RX 6800 má 88 %/92 %/89 % výkonu Radeonu RX 6800 XT a je o 13 %/13 %/10 % pomalejší než RTX 3080. Nad GeForce RTX 2080 Ti vyhrává podle ComputerBase o necelé procento, proti RTX 3070 zase o 1 % těsně prohrává, ale podle techPowerUp jsou obě tyto karty o 1 % pomalejší než Radeon RX 6800 a u Tom's Hardware je porazil dokonce o 5 % a 6 %. Dále je RX 6800 o 30 %/28 %/31 % rychlejší než GeForce RTX 2070 Super (o 16 %/14 %/19 % proti RTX 2080 Super) a o 40 %/35 %/39 % rychlejší proti RX 5700 XT.

1440p

Pokud se zvýší rozlišení na dnes asi nejrelevantnějších 2560 × 1440 bodů, odlepí se GeForce RTX 3090 trošku a Radeon RX 6800 XT už na ní ztrácí 13 %/9 %/9 %, ale proti RTX 3080 je pořád pomalejší jen o 5 %/4 %/0,3 % (v testu Tom's Hardware se zde Radeon téměř dotáhl, už ale není rychlejší jako v 1080p). Karta AMD je o 20 %/19 %/23 % rychlejší než GeForce RTX 3070 a o 21 %/19 %/20 % proti RTX 2080 Ti. Zvětší se i odstup od Radeonu RX 5700 XT na 77 %/69 %/70 %.

Levnější Radeon RX 6800 je v 1440p trošku dál, má už jen 86 %/90 %/88 % výkonu modelu RX 6800 XT; proti GeForce RTX 3080 je o 19 %/13 %/12 % pomalejší. Je ale o 3 %/7 %/8 % rychlejší než RTX 3070 a 4 %/7 %/6 % proti RTX 2080 Ti. Karta je o 40 %/41 %/39 % rychlejší než RTX 2070 Super a o 23 %/23 %/24 % rychlejší než RTX 2080 Super. Proti Radeonu RX 5700 XT je RX 6800 o 52 %/53 %/50 % rychlejší.

4K

V rozlišení 4K je Radeon RX 6800 XT zase o 5 %/6 %/4 % pomalejší než GeForce RTX 3080, ale na RTX 3090 ztrácí už 15 %/14 %/15 %. Je však už o 23 %/25 %/25 % rychlejší než GeForce RTX 2080 Ti Founders Edition a o 25 %/25 %/28 % rychlejší než GeForce RTX 3070. Proti Radeonu RX 5700 XT je o 89 %/89 %/86 % rychlejší.

Slabší Radeon RX 6800 se v tomto rozlišení také vzdálí, už má jen 80 %/87 %/86 % výkonu modelu XT. V tomto rozlišení ale má o něco větší náskok na RTX 2080 Ti (o 6 %/9 %/8 % víc výkonu) a RTX 3070 (Radeon má o 7 %/9 %/11 % víc výkonu). Náskok na RTX 2080 Super je už 29 %/30 %/29 %, na RTX 2070 Super 46 %/50 %/48 % a na Radeon RX 5700 XT 62 %/60 %/60 %.

Shrneme-li to podle prostředního rozlišení, je Radeon RX 6800 XT o 0–5 % pomalejší proti GeForce RTX 3080, proti níž stojí o 50 $ méně. Zároveň má nižší spotřebu a větší paměť. Radeon RX 6800 je pak o průměrně dejme tomu 6 % rychlejší než GeForce RTX 3070, proti níž ale stojí o 80 $ víc, byť opět nabízí větší paměť. Poskytuje průměrně asi 88 % výkonu RX 6800 XT – v 1080p o trošku víc, v 4K o trošku míň.

Výkon v ray tracingu se propadá o hodně víc než u Ampere

Výkon Radeonů RX 6000 a architektury RDNA 2 je ale zdá vychýlen víc ve prospěch klasických rasterizačních her než u Ampere. Pokud se totiž zapnou raytracingové efekty, sníží se výkon dost výrazně – více, než u grafik RTX 3000. Teoreticky je sice možné, že se ještě něco zlepší prací na ovladačích, ale s tím nelze zdaleka počítat jako s jistotou. V některých hrách se momentálně také objevila rozdílná kvalita nebo chyby v obraze – zatím nevíme, jestli jde jenom o bugy, jejichž oprava výkon neovlivní, nebo tyto nekonzistence snižují zátěž Ray Acceleratorů a FPS uměle zvýšili.

Radeon RX 6800 XT v sestavě her s raytracingovými efekty vychází podle Tom's Hardware v rozlišení 1080p na 80 % výkonu GeForce RTX 3080 a jen těsně (o 1 %) rychlejší než RTX 3070. V rozlišení 1440p má 79 % výkonu RTX 3080 a proti RTX 3070 je o 4 % rychlejší. V rozlišení 4K má 77 % výkonu RTX 3080 a je o 11 % rychlejší než RTX 3070, ovšem bavíme se o průměrné frekvenci 27,3 FPS (35,6 pro RTX 3080).

U ComputerBase to vychází o něco níž, RX 6800 XT má 76 % výkonu RTX 3080 v rozlišení 1080p, 74 % v 1440p a 76 % ve 4K. Proti RTX 3070 vychází o 0–4 % pomalejší.

Levnější Radeon RX 6800 pak u Tom's Hardware vychází v 1080p o 13 % pomalejší než RTX 3070, v 1440p je o 11 % pomalejší a ve 4K je o 6 % pomalejší než RTX 3070. U ComputerBase je o 17 % pomalejší než RTX 3070 v 1080p, o 14 % pomalejší v 1440p a o 15 % ve 4K.

Všechny grafy se zprůměrovanými výsledky najdete zde v galerii.

Galerie: Výkon grafik AMD Radeon RX 6800 a Radeon RX 6800 XT ve světových recenzích

Připravenost na budoucnost: výkon v RT versus velikost paměti

Z toho vyplývá, že Radeony RX 6800 (XT) jsou silné hlavně v množině klasických her, případně v soutěživém multiplayerovém hraní, kde raytracingové efekty zapínat nebudete chtít. GeForce RTX 3000 jsou výhodnější, pokud vám závisí hlavně na tom, jak vám půjdou raytracingové efekty ve hrách, kde je bude možné zapnout (respektive budete to chtít udělat).

Současně také karty Nvidia nabízejí AI upscaling DLSS, který za cenu vykreslování ve sníženém rozlišení (takže výsledná kvalita by měla být horší než nativní, i když DLSS zároveň vyhlazuje a ostří, takže má i svá pozitiva) zvýší snímkovou frekvenci. AMD pro Radeony také nějakou podobnou funkci chystá (FidelityFX Super Resolution), ale bude se počítat pomocí výpočetních jednotek a ne tensor jader jako u Nvidie, takže bych očekával menší nárůsty výkonu než s DLSS.

Částečně lze tedy možná říci, že grafiky Nvidia jsou více „připravené na budoucnost“, jak se někdy říká, kdežto Radeon může být výhodnější pro aktuální hry. Na druhou stranu ale tuto charakteristiku zase kazí to, že RX 6800 a RX 6800 XT mají 16 GB paměti, kdežto karty Nvidie jen 8 a 10 GB; v tomto jsou tedy zase více perspektivní Radeony (v recenzích padla zmínka, že se již situace, kdy tato paměť pomáhá, respektive její absence konkurenční kartu brzdí, začaly objevovat, byť to není nějak časté). V tomto to s výhledem na budoucnost tedy není tak jednoznačné.

Smart Access Memory: bonus s Ryzenem 5000

Předchozí výkonnostní údaje z recenzí jsou pořízené s procesorem Intel Core i9–9900K, neboť to je CPU, které mají weby dlouhodobě v metodice, jen ComputerBase měřilo na Ryzenu 9 3900XT. Toto znamená, že ve výsledcích není započítán vliv funkce AMD Smart Access Memory. Ta slibuje vylepšení výkonu grafiky při spárování s procesorem generace Ryzen 5000.

Ovšem je nutné pro to zapnout volbu Smart Access Memory v BIOSu a zatím je dostupná jen u několika málo desek platformy B550/X570 (Oprava: těch desek asi nebude až tak málo, MSI nyní oznámilo vydání podpory v nových BIOSech pro všechny své desky s čipsetem generace 500). Většina uživatelů k ní tedy pravděpodobně nebude mít přístup a navíc Nvidia chystá časem něco podobného. Tudíž není nefér, že zatím není zohledněna.

Bez AMD Smart Access Memory může procesor přistupovat jen k 256 MB paměti na grafice najednou (Zdroj: AMD)

Bez AMD Smart Access Memory může procesor přistupovat jen k 256 MB paměti na grafice najednou (Zdroj: AMD)Podle techPowerUpu Radeon RX 6800 XT i bez Smart Access Memory s Ryzenem 9 5900X možná dopadá lépe než se starším procesorem Intel, s nímž recenze proběhly – v 1080P má být jen o 2 % pomalejší a v 1440p o 1 %, ve 4K o 6 %. Smart Access Memory prý v průměru ve všech rozlišeních přidá Radeonům dva procentní body. V 1080p je pak ze souboje grafik plichta a v 440p dokonce Raeon RX 6800 XT urve těsné jednoprocentní vítězství.

K něčemu tato funkce šťastlivcům, kteří ji budou moci aktivovat, tedy evidentně je. I když možná větší pozornost si zaslouží, že se postavení Radeonu RX 6800 XT ve výsledcích zdá se trošku zlepšilo i bez Smart Access Memory, jen samotným použitím rychlejšího procesoru s architekturou Zen 3. Výkon se silnějším CPU zdá se víc narostl Radeonům než kartám GeForce.

Provozní vlastnosti referenčních karet: tentokrát dobrá práce?

Velkou – a předem avizovanou – změnou k lepšímu je, že v této generaci Radeonů mají i referenční karty chladič, jenž používá kvalitnější typ chlazení s otevřeným pasivem přes celou délku karty a s třemi axiálními ventilátory. U Radeonu RX 6800 je tlustý dva sloty (třetí byste ale měli nechat volný), u Radeonu RX 6800 XT je chladič tlustý dva a půl slotu. Oba modely ale mají stejnou délku 26,7 cm.

Radeon RX 6800 XT dostal 300W TDP a v testech ho zdá se dodržuje. Lze zapnout tzv. Rage Mode, který zvýší limit na 320 W (jako je TDP GeForce RTX 3080), pak má karta vyšší frekvence a výkon. Radeon RX 6800 má 250W TDP a také by ho neměl překračovat – někde recenze dokonce naměřily při hraní o dost méně (ComputerBase 231 W), ale to může být i výjimka či anomálie. Rage Mode by snad měl limit zvyšovat na 270 W.

Excelentní hlučnost u referenční karty (RX 6800 XT)

Dobrá zpráva je, že referenční chladič má funkci fan stop, při nízké zátěži se tedy ventilátory úplně zastaví a je ticho. Vypadá to ale, že chladič se možná dost překvapivě povedl, i pokud jde o zátěž. Podle techPowerUpu je Radeon RX 6800 XT jednou z nejtišších karet, kterou v testu měli, přičemž teploty byly 77°C (hotspot 98°C, zatímco karta má zvládat až 110°C neomezeně dlouho).

Galerie: Referenční provedení grafiky AMD Radeon RX 6800 XT, oficiální vizualizace

Hlučnost je výrazně nižší, než čím se může pochlubit GeForce RTX 3080 Founders Edition od Nvidie i se svým speciálním airflow zlepšujícím designem. Zatímco u té naměřil techPowerUp 36 dB, u referenčního Reaeonu RX 6800 XT pouze 31 dB, což by měla být výrazně méně než poloviční intenzita hluku (u ComputerBase byl výsledek 37 proti 42,5 dB, takže podobný rozdíl). Referenční provedení tedy zdá se rozhodně není pro ostudu a díky třem ventilátorům dokáže v této generaci chladit lépe než design Nvidie (minimálně v podmínkách recenzí).

Levnější Radeon RX 6800 už bohužel dopadl hůře. Je hlučnější než GeForce RTX 3070 Founders Edition, která je stejně tichá (nebo i tišší, 30 dB) jako RX 6800 XT. TechPowerUp naměřil u RX 6800 hlučnost v zátěži 34 dB (pořád ale o dost tišší než RTX 3080 FE s 36 dB), ComputerBase pak 41 dB proti 37 dB u RTX 3070 Founders Edition a 42,5 dB u RTX 3080 Founders Edition. I tak je to ale hlučnost slušná a lze si odškrtnout, že referenční chladič není na škodu. Teplota je navíc o dost nižší než u RX 6800 XT (70°C, hotspot 83°C), takže byste nejpíš ručně mohli ventilátory zpomalit. Možná, že ona horší hlučnost proti skvělému modelu XT by se tím o dost omezila.

Galerie: Referenční provedení grafiky AMD Radeon RX 6800, oficiální vizualizace

Nereferenční karty by měly být dostupné zhruba o týden později než referenční. Také jich asi ze začátku bude menší výběr. U těch by asi hlučnost často mohla být ještě lepší a také by například někdy mohly mít tři výstupy DisplayPort místo dvou a třetího nahrazeného USB-C, čímž jsou osazené referenční modely.

Výstupy zvládnou až 8K. Obrazové výstupy podporují až rozlišení 8K. Už je také potvrzeno, že dekodér videa zvládne dekódování formátu AV1 také až s rozlišením 8K. GPU umí komprimovat 8K video, ale jen do HEVC (zde má být kvalita enkodéru vylepšena proti předchozí generaci, jak moc, to se uvidí), podobně jako u Nvidie a Intelu není zatím přítomen enkodér pro AV1.

Návrat konkurence v nejvýkonnějších grafikách

Celkově byly karty přijaty docela dobře, v recenzích zdá se i často dostaly ocenění (například u PC Perspective, techPowerUpu „Editor's Choice“), a to i přes onen horší výkon v ray tracingu. Zejména u modelu Radeon RX 6800 XT je asi adekvátně nižší cena proti GeForce RTX 3080, které je počin AMD velmi blízko a navíc má onu omílanou větší paměť.

Radeon RX 6800 obnáší větší nárůst v ceně proti RTX 3070 (výhoda paměti je u něj také, teoreticky ještě větší). Úplně neadekvátní to také asi není, ale pro GeForce RTX 3070 díky tomu vychází o něco lepší poměr cena/výkon, pokud paměť ignorujete.

Nové Radeony tak vypadají jako grafiky, s kterými neuděláte chybu a jsou s kartami od Nvidie poměrně vyrovnané. Možná nejdůležitější je, že tímto takováto vyrovnaná konkurence až v segmentu obsazeném modelem GeForce RTX 3080 opět existuje, protože v posledních letech si Nvidia osobovala oblast nejvýkonnějších karet jen pro sebe. Příští měsíc vyjde ještě Radeon RX 6900 XT, který by se mohl dostat ještě o kousek výš, i když GeForce RTX 3090 od Nvidie asi bude pořád v grafech okopávat zespodu a ne seshora.

Jak podotkl redaktor techPowerUpu, ještě před docela nedávnem se objevovaly názory, že Nvidia ujela v grafikách tak dalece, že už ji AMD nemůže dohnat. Radeony RX 6000 se ovšem dostaly dostatečně blízko, aby se dalo mluvit o konkurenci zcela plnohodnotné a AMD pro někoho překvapivě tedy tyto pesimistické názory rozptýlilo.

Toto je asi ta nejpozitivnější zpráva, i když je dobré pamatovat, že trošku přispěla i sama Nvidia. Totiž když (asi kvůli vyšším ziskům) zvolila pro herní grafiky Ampere horší 8nm proces Samsungu místo již dostupného 7nm procesu TSMC, což jí stojí energetickou efektivitu. Ale to je byznys, je možné, že když AMD vyrábělo GPU u GlobalFoundries (Vega, Polaris) možná také mělo určitou nevýhodu.

Vzhledem k tomu, že již předchozí generace Radeonů Navi RX 5700 byla vyráběna stejným 7nm procesem, AMD dosáhlo většinu zlepšení, které teď Radeony RX 6000 přinášejí, ne procesem, ale architektonickými zlepšeními. Tudíž až se – možná v příštím cyklu na 5nm procesu – oba konkurenti srazí na rovnocenné výrobní technologii, nemusí to znamenat, že bude AMD zase automaticky pozadu.

Zdroje: Tom's Hardware, techPowerUp (1, 2, 3), PC Perspective, ComputerBase