Nvidia pořádá nyní svou konferenci GTC 2024 a tento rok je s ní spojené odhalení nové architektury a generace GPU a AI akcelerátorů Blackwell. Firma představila první čip – respektive čipletové řešení založené na této architektuře – s označením B200, přinášející opět velké pokroky ve výkonu umělé inteligence. Ovšem také nárůst spotřeby a dost možná i ceny, protože B200 má dvakrát víc křemíku než H100 nynější generace.

B200

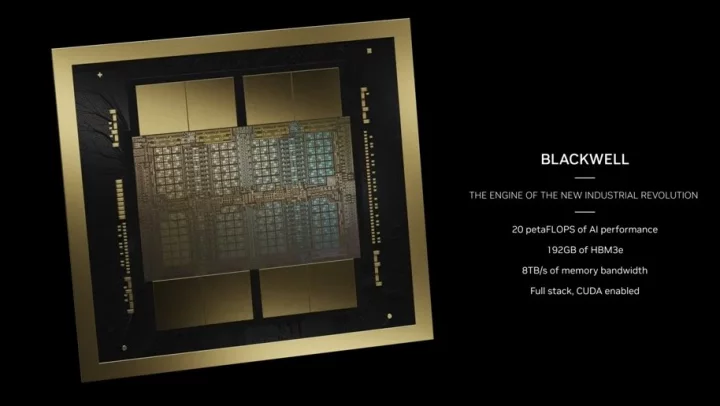

Odhalení GPU Nvidia B100 přichází dva roky po odhalení 4nm H100 s architekturou Hopper. To byl ještě monolitický čip, nový B200 je místo toho poprvé čipletový, GPU je rozdělené do dvou propojených čipletů, což umožnilo výrazně navýšit plochu, kterou může využít. Architektura Blackwell, kterou používá, je pojmenovaná po Davidu Haroldu Blackwellovi, americkém matematikovi a statistikovi.

Každý z čipletů tvořících B200 obsahuje 104 miliard tranzistorů (celek tedy má 208 miliard). Nemáme informace o ploše, ale oba čiplety jsou údajně na maximální ploše, kterou lze v TSMC vyrobit, tedy tzv. reticle limitu, který je někde mezi 800–850 mm². Doteď neoficiálně kolovala informace, že bude použitý 3nm proces, ale nakonec tomu tak není. Nvidia oznámila, že je použitá technologie N4P, což je evoluce custom procesu 4N (použitého u Hoppera a Ada Lovelace) se zvýšeným výkonem.

Nvidia B200 Blackwell. V tomto pouzdru jsou dva propojené výpočetní čiplety a 8× pouzdro paměti HBM3E

Obě poloviny GPU jsou propojené širokou sběrnicí NV-HBI (Nvidia High Bandwidth Interface) a z pohledu softwaru tvoří jediné GPU. Kapacita propojení obou segmentů je 10 TB/s, což pravděpodobně znamená 5 TB/s jedním směrem a 5 TB/s druhým současně, protože ve specifikacích tohoto typu se obvykle u duplexního rozhraní sčítají oba směry. Nvidia zatím neprozradila, zda je pro přemostění obou čipletů použitá technologie Chip-on-wafer-on-Substrate (CoWoS), podkladový čiplet, nebo interposer.

Celé GPU používá celkem 8192 bitů široké paměti HBM3E – každý z čipletů má čtyři 1024bitová rozhraní se čtyřmi pouzdry HBM3, což dává 2× 4096bitovou sběrnici, 2× 96 GB paměti (takže celek má kapacitu 192 GB paměti) a 2× 4 TB/s propustnosti, protože paměti mají efektivní frekvenci 8,0 GHz. GPU také obsahuje rozhraní NVLink 5. generace pro propojení s dalšími GPU v klastru, ty mají celkově (v součtu všech rozhraní oběma směry) mít propustnost až 1,8 TB/s.

2,5× vyšší výkon pro AI, ale horší v FP64

Nvidia sdělila výkonnostní čísla, která jsou zjevně zaměřená na zvýšení AI výkonu, zatímco ve vědeckých výpočtech by, zdá se, B200 mohlo být regresí. Výkon ve výpočtech FP64 má být 45 TFLOPS na tensor jádrech a zřejmě jen 22,5 TFLOPS v běžných výpočtech mimo tensor jádra. Hopper H100 by měl mít na tensor jádrech 60 TFLOPS a 30 TFLOPS ve vektorových výpočtech mimo tensor jádra. B200 má tedy zřejmě jen 75 % výkonu Hopperu ve vědeckých výpočtech, které, jak je vidět, už Nvidii asi moc netrápí, protože jde o malý trh proti AI akceleraci.

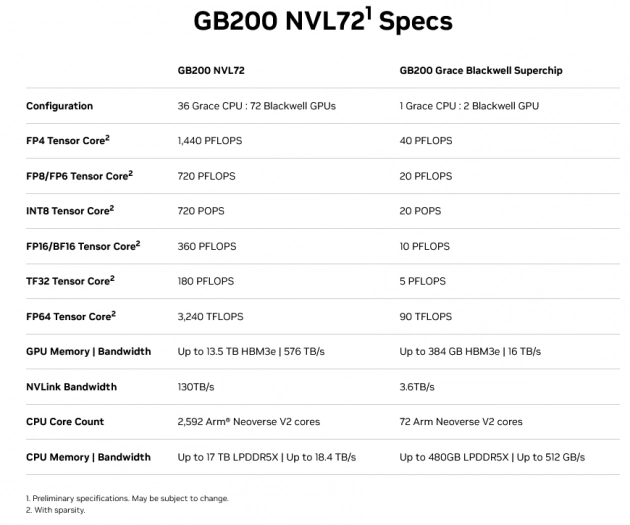

V AI výpočtech má ale B200 podle Nvidie dosahovat 2,5 PFLOPS výkonu ve výpočtech FP16 či BFloat16 na tensor jádrech, 5 PFLOS v INT8 a FP8. Blackwell má používat druhou generaci „Transformer Engine“, s níž jsou podporovány dokonce výpočty i s datovým typem FP6 (tam je výkon stejný jako u FP8), a dokonce FP4. To by to mělo znamenat hodně špatnou přesnost (je to floating point číslo s jen 16 možnými hodnotami), ale s dvojnásobným výkonem 10 PFLOPS. Při použití sparsity Nvidia uvádí dvojnásobné hodnoty.

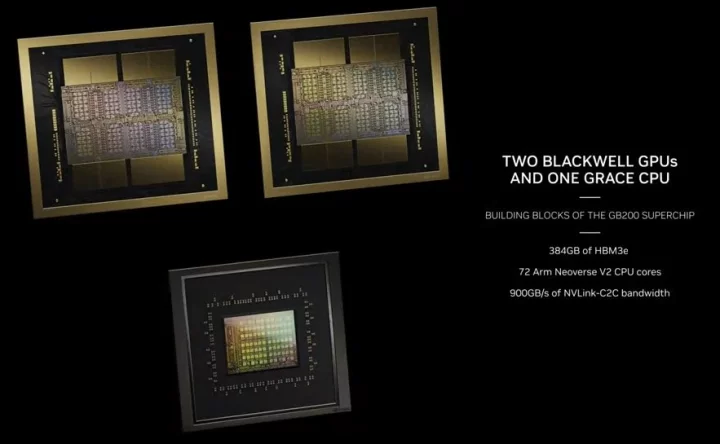

Obecně je v těchto specifikacích trošku nepořádek, protože Nvidia se je rozhodla rovnou uvádět pro dvojici GPU zapojených do tzv. GB200 Grace Blackwell Superchip spolu s ARM procesorem (každé s dvěma čiplety), a navíc ještě včetně sparsity, takže v její tabulce jsou zřejmě čísla čtyřnásobná proti teoretickému fyzickému výkonu jednoho B200.

Proti Hopperu H100 by tedy v AI výpočtech mělo zřejmě vycházet mezigenerační navýšení výkonu o 150 % (na dvouapůlnásobek). Čistě jako výkonnostní zlepšení je to slušné. Rozdíl mezi generacemi Volta a Ampere byl podobný (2,5×), ovšem mezi Ampere a Hopper o něco vyšší (3,2×). Blackwell tento nárůst ovšem realizuje při potřebě dvojnásobného množství křemíku a při vyšší spotřebě (avšak je to také bez využití nového výrobního procesu). Toto se asi může promítnout do dalšího zvýšení ceny, která je už u H100 nyní velmi vysoká (údajně až 40 000 $).

Spotřeba 700 W až 2700 W

Akcelerátor B200 bude Nvidia vyrábět ve třech provedeních. Nejvýkonnější provedení bude tzv. GB200 Grace Blackwell Superchip, což je kombinace dvou GPU B200 se 72jádrovým ARM procesorem Grace, který již Nvidia spojuje s GPU Hopper (a oznámila ho papírově již před lety, ale reálně přišel mnohem později).

Jedna tato jednotka má TDP 2700 W, takže na jedno GPU B200 asi připadá více než 1000 W. Bude základem serverových racků od Nvidie nazvaných GB200 NVL72, které budou obsahovat 36 instancí, tedy 36 procesorů a 72 GPU B200. Chlazení bude vodou, jedná se o kompletní rack s 18 1U servery, kde každý je tvořený dvěma GB200 Grace Blackwell Superchipy.

Druhá dvě provedení používají provedení SXM, což je mezaninový formát s jedním GPU. Servery HGX B200 používají akcelerátory B200 se spotřebou 1000 W a vyžadují nové desky. Jeden server či deska bude mít jeden x86 procesor a k tomu osm akcelerátorů B200. Výkon s touto spotřebou by měl být nižší než u verze GB200 Grace Blackwell Superchip, zřejmě jsou snížené frekvence kvůli nižšímu TDP. Nvidia uvádí jen 90 % výkonu – tedy 4,5 PFLOPS v INT8/FP8, 2,25 PFLOPS ve FP16 a tak dále.

Vedle toho ale bude také pomalejší verze serverů HGX B100, opět s konfigurací jedno CPU a osm GPU, ale v provedení B100, které se liší spotřebou sníženou na 700 W. Tato verze zřejmě bude kompatibilní se staršími servery určenými pro akcelerátory Hopper H100 a měla by snad být uchladitelná vzduchem. Výkon je ale snížený na zhruba 70 % oproti verzi GB200 Grace Blackwell Superchip – tedy 3,5 PFLOPS ve výpočtech INT8/FP8, 1,75 PFLOPS ve FP16 a tak dále.

Vydání někdy v letošním roce

Je třeba připomenout, že toto není ještě skutečné vydání akcelerátorů B200. Nvidia obvykle výpočetní produkty oznamuje dopředu v předstihu před reálným komerčním prodejem, takže tato odhalení jsou vždy jen papírová.

Blackwell ještě není reálně dostupný a skutečný termín vydání zatím Nvidia nesdělila. Produkty založené na GPU B200 prý mají být od partnerů Nvidie dostupné od termínu někdy „později v letošním roce“, pravděpodobně až v jeho druhé polovině, i když to přímo řečeno není.