Průsaky před vydáním grafik Ampere jsou zřejmě už nezadržitelné, protože v tuto chvíli se už i partnerští výrobci připravují na odhalení svých verzí karet. Ačkoliv se stále neprovalily kompletní specifikace, web VideoCardz teď přinesl důležitou část detailů, doplňující to, co jsme se ke kartám dozvěděli ve středu.

VideoCardz, jehož informace by měly být založené na tom, jaké karty chystají partnerští výrobci (a tím relativně ověřené), nyní píše, že během příštího měsíce, tedy v první vlně, Nvidia nakonec vydá hned tři modely. K prvním dvěma jsou specifikace takřka celé.

GeForce RTX 3090: 350 W…

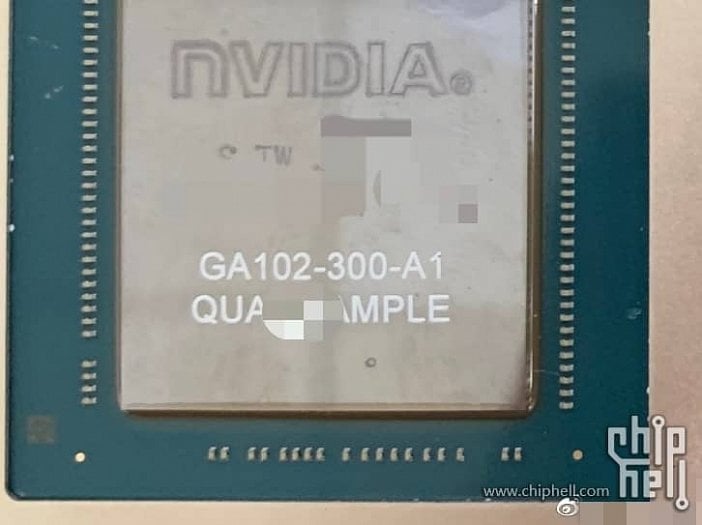

První bude nejvýkonnější varianta GeForce RTX 3090 s 24GB pamětí. Uvnitř má být čip GA102–300, tedy to, co nedávno uniklo na fotce. A teď to nové: tato karta bude mít 5248 shaderů/cuda jader/stream procesorů (říká se jim všelijak, ale hovořit o „jádrech“ není technicky správně). Boost by snad měl být 1695 MHz.

Paměť (jak již bylo známo dříve) dostala kapacitu 24GB a používá novou technologii GDDR6X. Sběrnice je 384bitová a nová informace je takt pamětí: 19,5 GHz efektivně. To kartě zajistí propustnost 936 GB/s.

VideoCardz také potvrdil dosud divokou zvěst o vysoké spotřebě: TDP, či přesněji řečeno spotřeba celé karty, je 350 W. Tyto hodnoty jsou pro nepřetaktované karty s referenčními frekvencemi.

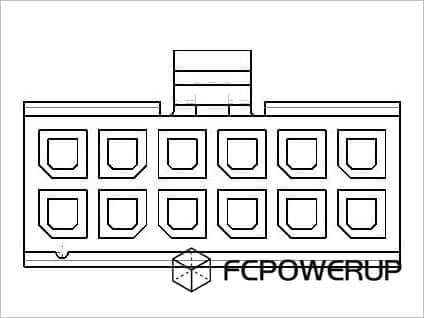

Podle VideoCardz budou karty od partnerských firem (tj. ty co běžněkupujete) mít napájení dvěma osmipinovými konektory, tedy úplně standardně. Nový dvanáctipinový konektor (snad jen jeden?) bude samozřejmě u karet Founders Edition od Nvidie, i když asi není vyloučeno, že ho vezme na milost i nějaký externí výrobce.

Galerie: Nový 12pinový napájecí konektor pro grafiky Nvidia GeForce RTX 3000/Ampere

GeForce RTX 3080: šance na 20GB model prý pořád je

Druhým modelem bude karta GeForce RTX 3080. Ta má, jak již bylo dříve vypuštěno, 10GB paměti GDDR6X na 320bitové sběrnici. Nyní VideoCardz doplňuje takt, ten je 19,0 GHz efektivně, což dodá propustnost 760 GB/s.

Podstatná informace ještě je, že je prý nakonec pořád ve hře 20GB verze (která by řešila výtka na relativně malou paměť, asi jde i optimálnější kapacitu než rovnou 24 GB). Tu snad prý (na vlastní pěst?) vytvoří výrobci karet jako nereferenční model. Ale údajně pro něj ještě není známé datum a není úplně jisté, kdy by tedy přišel – minimálně nebude dostupný hned při vydání.

A teď specifikace GPU: tento Ampere má mít stejný čip, ale ve variantě GA102–200. Už je ale poměrně dost oříznutý na „jen“ 4352 shaderů. Takt boostu by prý asi mohl být 1710 MHz.

Přes oříznutí GPU a méně než poloviční paměti nebude spotřeba této karty o moc nižší a také přeleze symbolickou třístovku. Celkové TDP karty je 320 W, opět prý pro referenční parametry, takže toto bude standardní hodnota přes OC. Karty partnerských výrobců budou mít napájení dvěma osmipiny, Founders Edition od Nvidie asi opět svůj 12pin.

GeForce RTX 3070: 8 GB, 220 W

Novinka je, že nyní je už známo i že do konce září reálně vyjde rovněž GeForce RTX 3070. Tato karta má odlišné GPU GA104 ve variantě GA104–300 (a také odlišné PCB PG142, kdežto předchozí dvě PG132). K této kartě není ještě znám počet shaderů ani takt, ale víme, že TDP karty bude 220 W.

Paměti zde zůstanou při starém. VideoCardz uvádí, že kapacita bude 8 GB, šířka sběrnice 256 bitů. A hlavně má jít o GDDR6, nikoliv GDDR6X. Pokud by Nvidia použila 16,0GHz frekvenci (to možná zatím není 100% jisté, ale mohlo by to nastat), tak by propustnost dělala 512 GB/s.

Zatím nejvyšší spotřeba single-GPU karty?

Spotřeby 320 a 350 W jsou na jednočipové karty hodně vysoká, vyšší než například u značně kritizovaného Radeonu RX Vega 64, jemuž „stačilo“ 295 W (dokonce jde Ampere i výš než speciální vodní edice Vegy, ta těsně prohrává s 345 W).

Nakonec snad 7nm technologie

Trošku to už začínalo vypadat, že vysoká spotřeba by mohla být proto, že Nvidia použila horší výrobní proces 10nm třídy (8nm proces Samsungu). Ovšem pozor, podle VideoCardz dokumenty, které získal, hovoří explicitně o tom, že GPU je 7nm. Nebo minimálně GA102 je, u GA104 to asi zatím nikde není zmíněno. Zda jde o 7nm proces Samsungu (ten by byl s EUV) nebo TSMC (ten může být s EUV i bez), zatím potvrzené není.

Toto by znamenalo, že energetická efektivita by pořád mohla být velmi vysoká. Jinými slovy, vysoká spotřeba by nemusela být proto, že GPU to lépe neumí, ale proto, že se do karet Nvidia rozhodla vecpat více výkonu. Výpočetní výkon je v GPU ve finále vždy omezován watty, takže když toto škrtidlo povolíte…

Vysoká spotřeba (320 W, 350 W) GPU Ampere/GeForce RTX 3000:

PCI Express 4.0, HDMI 2.1

Z dalších věcí je potvrzeno, že GPU Ampere budou už podporovat novou verzi HDMI – HDMI 2.1, které nese mnohá zlepšení a podporuje vyšší rozlišení. DisplayPort zůstane na verzi 1.4a. Karty také mají už i podporu PCI Expressu 4.0 (když už ji dostalo i zvláštní mobilní GPU GeForce MX450), takže využijí tento potenciál na aktuálních platformách (Ryzenech 3000 „Matisse“ od AMD, u Intelu si počkáte do příštího roku na Rocket Lake).

O změnách samotné výpočetní a grafické části zatím nic nevíme. Nvida v materiálech uvádí „Ray Tracingová jádra druhé generace“ a „Tensor jádra třetí generace“ (ta už známe z vydání serverového Ampere A100), ale bližší podrobnosti k nim ještě nejsou.

Galerie: Nvidia Ampere je tu: obří výpočetní GA100, 8192 shaderů. Architektura jde i do GeForce (Fotogalerie)

Zdroj: VideoCardz