Včera přišel 20. srpen, což kromě připomínky, jak málo už zbývá z prázdnin, také byl den, na který Nvidia naplánovala velkou veřejnou akci, na které podle očekávání došlo k odhalení nové generace herních grafik GeForce, založených na GPU Turing. Nvidia tuto novou architekturu představila z pohledu profi grafiky už minulý týden na Siggraphu. Ale nyní nastal čas ukázat, zač toho bude loket v herních kartách, což se odehrálo na veřejné prezentaci „BeForTheGame“, která údajně byla jedna z největších nebo úplně největších, jaké zatím Nvidia uspořádala.

Ray tracing na Turingu: zatím s trochou aproximace

Jak už víme od Siggraphu, velkou novinkou GPU Turing je podpora pro ray tracingovou grafiku, pro kterou mají tato GPU fixní hardware akcelerující některé výpočty – takzvaná RT jádra (RT cores). Jejich úlohou je urychlit inherentně velmi náročné výpočty ray tracingu, aby bylo možné je využívat pro standardní herní grafiku – nebo alespoň pro její část. Nyní spolu s odhalením karet GeForce RTX Nvidia prozradila, jak to s oním vykreslováním v reálném čase bude.

Jak už to chodí, v první generaci hardwaru s něčím podobně novým bývá podpora pro onu převratnou technologii trochu „pilotní“ a skutečně bezproblémově praktickou se stane až po pár dalších generacích. Zda to tak bude i u ray tracingu v GPU, to zatím nevíme. Ale co už asi jasné je: Turing ještě nebude kartou, která by dokázala utáhnout ray tracing standardně při dnes používaných rozlišeních – pro jeho použití se budou muset používat zkratky.

Zdá se, že tou hlavní zkratkou bude použití filtrů na bázi neuronových sítí. Nvidia již na jaře při oznámení DirectX Raytracingu tuto novinku avizovala pro GPU Volta, používá totiž Tensor Cores. A protože Tensor Cores jsou i v Turingu, bude právě tato technologie stěžejní pro ray tracing. O co jde? Při výpočtu ray tracingu je pro kvalitu zásadní, kolik paprsků světla na scéně analyzujeme, ovšem každý paprsek stojí výkon – podobně jako pixel při klasickém vykreslování. Pokud snížíme rozlišení, je klasická grafika rychlejší. A pokud zredukujeme počet paprsků, je zase ray tracing rychlejší. Ovšem toto má dopad na kvalitu – v tradiční grafice dostanete pixelizaci, viditelný hrubý rastr bodů. V ray tracingu je to podobné, ale primárním jevem je, že obraz trpí šumem – nedostatek paprsků vytváří pixely, které nemají správný odstín. Humorně to ilustruje tento aktuální vtip z twitteru.

Ono zapojení umělé inteligence je jednoduché. Nvidia sestavila sadu dat sestávající se z obrazů vyrenderovaných kvalitně s velkým množstvím paprsků a stejných obrazů s nižší kvalitou a oním šumem. Poté na těchto datech vytrénovala filtr na bázi neuronových sítí, který se snaží interpolovat nekvalitní obraz tak, aby vypadal jako ten kvalitní – jde tedy o odšumovací interpolátor na bázi strojového učení. Nvidia tomuto filtru přezdívá DLSS, Deep Learning Super-Sampling.

Předtrénovaný postprocesing pro zakrytí nedostatků

Tento efekt se používá jako post-processing a pro jeho výpočty běží na tensor cores v GPU Turing. Efekt je to vlastně podobný, jako kdybyste vykreslovali tradiční grafiku s nízkým rozlišením a poté aplikovali postprocessing s vytrénovaným interpolátorem provádějícím upscaling na vyšší rozlišení. Výsledek bude ostřejší a více „koukatelný“, ale jak už to u podobných filtrů chodí, nebude zdaleka vypadat tak dobře, jako by vypadal reálný obraz s plnou mírou detailů. Paralelu lze vztáhnout třeba i k technikám vykreslování jako je Checkerbox rendering na konzolích, kde také jde o redukci vykreslovaného rozlišení a interpolaci chybějící informace.

Při dnešních možnostech hardwaru je ale asi tento přístup nutný a tento filtr bude zdá se bude hrát velkou roli v tom, jak budou Turingy ray tracing zvládat. Díky tomu, že skutečný ray tracing bude prováděn s podstatně nižším množstvím paprsků, bude možné právě dosáhnout vykreslování v reálném čase. Čas, který GPU bude potřebovat k použití filtru DLSS, bude totiž mnohem kratší, než co by potřebovalo reálné dopočítání scény na plnou kvalitu. Jak velký bude dopad na kvalitu a zda se třeba neobjeví artefakty, kterými rasterizační grafika netrpí, to také teprve uvidíme, až bude možné podrobně analyzovat obraz ve hrách.

Jak ray tracing vypadá?

Na akci Nvidia ukazovala několik dem a ukázek z her, které mají nějaké použití ray tracingu přinést (Shadow of the Tomb Raider, Metro Exodus, Battlefield V). Z těchto dem vyplývá, že přínos pro kvalitu obrazu bude v osvětlení a ve stínech. Ray tracing za cenu vysoké náročnosti kvalitně simuluje odlesky a odrazy (včetně odrazu v zrcadle) a umí vytvořit realisticky vypadající stíny. V ukázkách to vypadalo velmi pěkně, ale závěry si samozřejmě bude třeba udělat až v praxi.

Ray tracing naopak zachovává klasické polygonové modely a textury 3D scény, takže pokud jste čekali, že už věci budou „kulaté a ne hranaté“, tak toto ray tracing nemění. (To jen tak pro pořádek, protože jsem se s touto otázkou setkal.)

Článek pokračuje na další straně specifikacemi nových karet GeForce RTX.

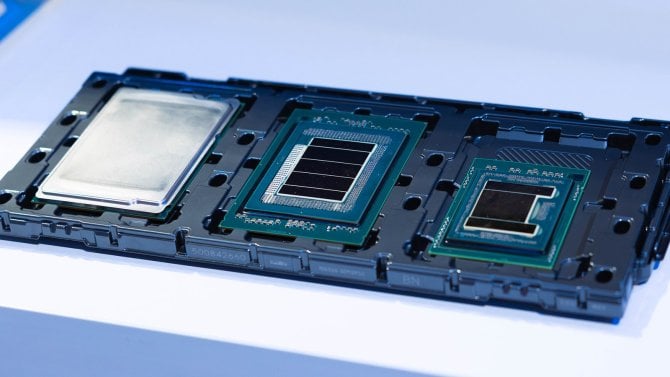

První tři karty GeForce RTX jsou na světě

Prezentace dem a výše zmíněné kombinace skutečného ray tracingu a redukovaného vykreslování s interpolací pomocí DLSS tvořila většinu celé dvouhodinové předváděčky. Nakonec ale přece jen byly odhaleny ony GeForce RTX s čipy Turing, na které už teď všichni čekáte. Jen-Hsun Huang si nejdřív dělal legraci, že pro ray tracingové hraní bude potřeba server DGX s čtyřmi Teslami V100 stojící 80 000 dolarů (dokonce nabídl předobjednávky), ovšem díky RT cores a tensor cores provádějícím filtr DLSS naštěstí mají podobný výkon dosáhnout i GPU Turing. Ty nakonec Nvidia odhalila tři.

GeForce RTX 2080 Ti

Vezmeme to od nejvýkonnějšího a nejdražšího modelu. GeForce RTX 2080 Ti už známe částečně z úniku, o kterém jsme psali v neděli. Jde o kartu, založenou na čipu TU102, jenž je stejný jako v Quadru RTX 8000 a 6000. Ale v kartě GeForce RTX 2080 Ti je ořezaný na na 4352 stream procesorů (tato varianta má dle VideoCardz označení TU102–300A). Základní frekvence GPU je 1350 MHz, boost Nvidia uvádí 1545 MHz. Karta má stanoveno 250W TDP, tedy jako GeForce GTX 1080 Ti. Podle Nvidie zvládá toto GPU při ray tracingu zpracovávat okolo 10 giga paprsků za sekundu.

Co je dále ořezáno, jsou paměti. Stejně jako u 1080 Ti Nvidia mírně opižlala sběrnici, místo 12 čipů GDDR6 je použito jen 11. Karta má tedy 11 GB paměti GDDR6 a 352bitovou sběrnici. Paměti běží na frekvenci 14,0 GHz efektivně, což dává propustnost 616 GB/s. Doporučená koncová cena je ovšem vyšší, než v předcházejících generacích: 999 dolarů, což teď s DPH vychází asi na 27 100 korun.

Founders Edition se vrací

Ovšem pozor, toto je doporučená cena, takže karty se mohou pohybovat nad ní podle toho, zda budou nabízet přetaktování z továrny, lepší chladiče a tak podobně. Nvidia u těchto karet opět oprášila nápad se svou vlastní „Founders Edition“ verzí. A stejně jako u Pascalů, karty Founders Edition stojí víc. A to dokonce o hodně – za RTX 2080 Ti v provedení FE chce Nvidia rovnou 1199 dolarů, tedy cenu jako za Titan Xp. Karta přímo od Nvidie tedy vyjde na něco okolo 32 550 Kč (aktualizováno: oficiální česká cena je 32 700 Kč). Ovšem tentokrát to alespoň bude znamenat vyšší kvalitu provedení než tehdy. Karty Founders Edition totiž už nejsou referenční, ale přetaktované (GPU má mít boost až 1635 MHz). A co je důležitější – používají kvalitnější chladič s dvěma axiálními ventilátory. Takže by na tom s chladícím výkonem a hlučností měly být podobně dobře jako nereferenční modely (toto bývala velká slabina karet FE i Titanů).

Reálně se asi karty budou cenově pohybovat mezi doporučenou cenou a cenou za FE přímo od Nvidie. Časté by asi mohly být částky 1050–1100 $, ale naštěstí se v únicích předcházejících vydání objevily i nějaké modely „jen“ za rovnou tisícovku, takže na cenu citliví by asi měli mít šanci. Tedy pokud odhlédneme od toho, že oněch tisíc dolarů za jednu grafiku je pořád hodně vysoká částka. Není to tak dávno, co vyloženě highendové grafiky stály polovic a Titan se považoval za kartu pro snoby nebo pro propagační účely. Hráčský hardware nejen v oblasti GPU asi kráčí tak trošku cestou módního průmyslu a různých „prémiových produktů“.

Aktualizováno: v českých eshopech se teď objevují možnosti předobjednávek GeForce RTX 2080 Ti, ale až za částky začínající na 32 600 korun. Což je cena Founders Edition, ačkoliv jde o nereferenční karty s custom chlazením. Většina modelů je nicméně dražších, až okolo 35 tisíc a výš.

GeForce RTX 2080

O stupínek níž Nvidia nabízí kartu GeForce RTX 2080 už bez přídomku Ti. Ta je založená na čipu TU104–400A. Má mít 3072 stream procesorů/shaderů, zde je však ořezaný na 2944 jednotek. Základní frekvenci má 1515 MHz, jeho Boost je 1710 MHz. Toto GPU má stanoveno TDP 215 W, což je vyšší hodnota než u GTX 1080. Paměti dostaly kapacitu 8 GB a jsou také typu GDDR6 s frekvencí 14 GHz efektivně. Sběrnice je 256bitová, což dává propustnost 448 GB/s. GPU má zvládat zpracovat zhruba 8 gigapaprsků za sekundu – tedy velmi zhruba 80 % výkonu modelu Ti.

I karta 2080 bohužel byla zdražena proti tomu, co stála GTX 1080. Její doporučená cena je 699 dolarů, což vychází na 19 tisíc Kč. I zde však nastává komplikace s Founders Edition – verze FE od Nvidie má cenu 799 dolarů (aktualizováno: česká oficiální cena je 21 999 Kč). Karta Founders Edition je taktéž přetaktovaná, boost GPU je pro ní 1800 MHz. Chladič je také „nereferenčního charakteru“ s dvěma axiálními ventilátory.

Aktualizováno: v českých eshopech se teď objevují možnosti předobjednávek GeForce RTX 2080 až od 23 tisíc korun, tedy dokonce víc než za Founders Edition.

GeForce RTX 2070

Co už je ale překvapení, je ohlášení i třetího, levnějšího modelu, GeForce RTX 2070. V jeho případě nevíme, jaké GPU je použito, asi by mohlo jít o výrazně ořezané TU104. Tato grafika z něj bude mít aktivních jen 2304 jednotek, které mají základní takt 1410 MHz. Boost je 1620 MHz, nebo 1710 MHz u přetaktované karty Founders Edition přímo od Nvidie (ano, i u tohoto modelu bude FE existovat). RTX 2070 má zachovánu stejnou šířku sběrnice pamětí 256 bitů a zřejmě i frekvenci 14 GHz, stejně jako kapacitu 8 GB. Propustnost je tedy rovněž 448 GB/s. Model má TDP také o něco vyšší proti GTX 1070 – základní verze má udáno 175 W, Founders Edition 185 W.

GeForce RTX 2070 má stát „od 499 dolarů“ (13 600 Kč). Ovšem za Founders Edition nvidia chce už 599 $ (aktualizováno: česká oficiální cena je 16 400 Kč). I zde máme to potěšení pochválit, že Nvidia na svou kartu už nedá klasický profukovací chladič s radiálním ventilátorem, ale rověž chladič podobný nereferenčním s dvěma axiálními ventilátory. U této karty je udávaný výkon v ray tracingu 6 giga paprsků za sekundu, takže asi 60 % nejvyššího modelu a 75 % modelu 2080. Mimochodem, RTX 2070 FE má zdá se konektor DVI? Kdežto ostatní karty mají toliko HDMI 2.0b, DisplayPorty 1.4 a USB-C/VirtualLink.

Předobjednávky dnes, karty a recenze ale až za měsíc

Karty je možno od včerejška předobjednávat v obchodech, ale ještě docela dlouho je neuvidíte. Reálně mají totiž na pultech být až 20. září, tedy až za měsíc (jde tedy o odhalení papírovější, než bývalo v poslední době zvykem). Respektive, toto se asi týká modelů 2080 a 2080 Ti. GeForce RTX 2070 má zdá se vyjít až v říjnu a zatím na ní předobjednávky neběží.

Až v té době se také asi dočkáme recenzí, zatím tedy výkon nových GPU Turing zůstává neznámý. Nvidia totiž neukázala ani žádná marketingová srovnání výkonu v nějakých benchmarcích. Jediné, co na show dala k dispozici, byla srovnání v ray tracingu, kde všechny nové modely mají údajně násobně předčit rychlost Titanů generace Pascal. To nám ale moc neřekne, protože toto srovnání stojí čistě na RT Cores karet a nevíme ani, zda je kód běžící pro tyto účely na starších GPU zrovna optimální (jde přece jenom o marketingové srovnání). Jak si třeba Turingy povedou proti Pascalům nebo jiným GPU v tradičních hrách, tak momentálně lze jen tipovat…